獨家|「AI對齊」避免人工智慧出餿主意 專家:永遠做不完!要持續精進

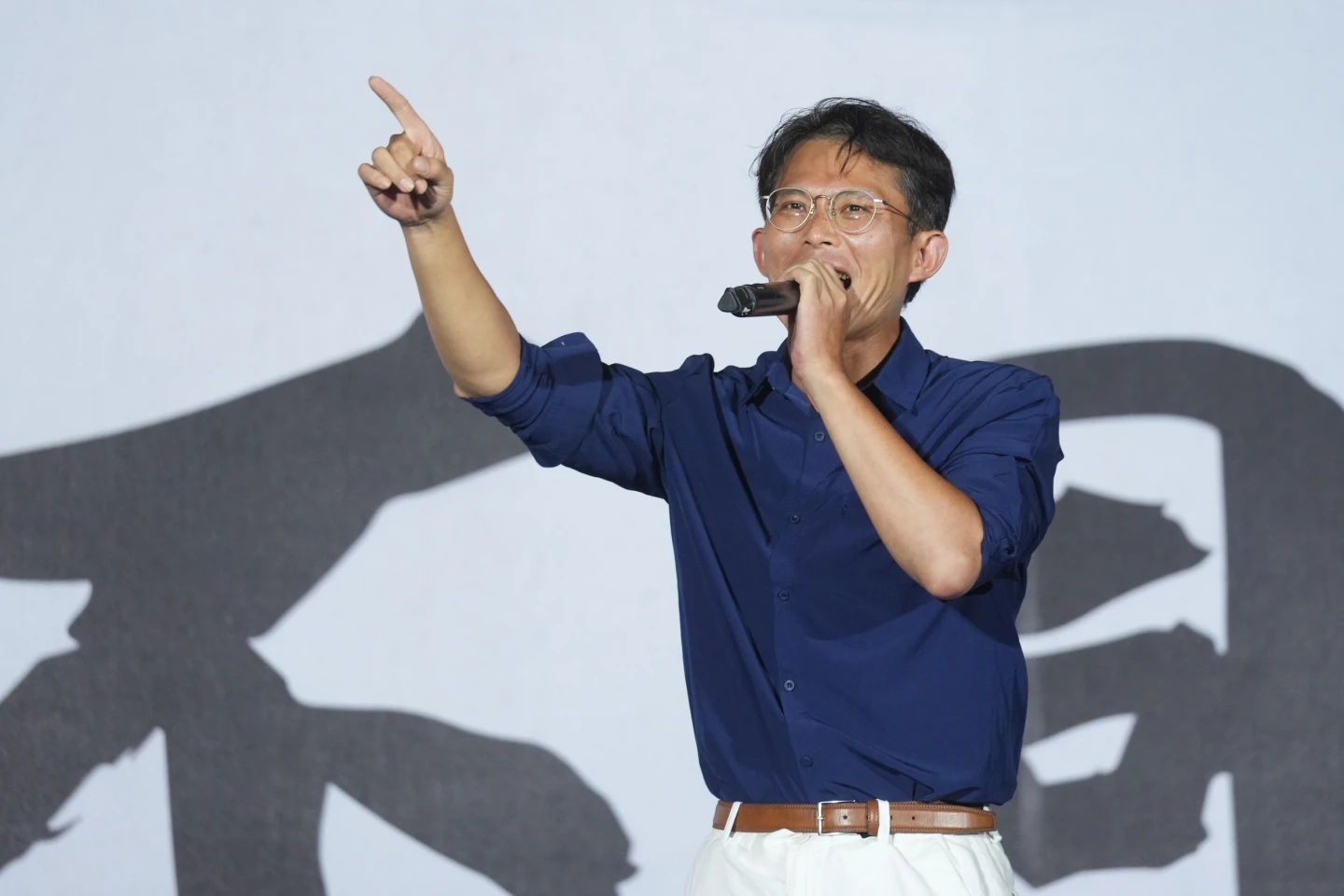

【記者王良博/台北報導】ChatGPT等人工智慧(AI)大型語言模型正夯,卻也衍生AI對齊問題(alignment problem)。陽明交大資訊工程學系特聘教授吳毅成解釋,當AI回答問題時,能不造成危害、符合期待,「不出餿主意」,即是「對齊」。他也指出,「對齊一定做不完」,就像資安、防毒技術,不可能做到100%擋下病毒或攻擊,AI對齊技術也要持續精進。

對於何謂AI對齊問題,吳毅成表示,ChatGPT等大型語言模型,在回答使用者問題時,符合使用者的期待、價值觀,避免造成危害,就是符合「對齊」。

他舉例,假設使用者詢問AI如何快速減肥,AI應該要回覆快速減重對身體有害,必須參考醫生意見,而非隨意拼湊各種資訊,否則可能讓使用者健康受影響,「不能出餿主意」。

另外,像是詢問AI如何侵入別人的Wi-Fi,若AI一五一十回答,也會造成社會問題,應該回答這是違法的行為。

值得注意的是,ChatGPT的開發商OpenAI,旗下風險控制團隊「超智慧對齊」(Superalignment)日前宣告解散。

針對「超智慧對齊」與一般AI對齊議題有何不同,吳毅成說,AI圍棋軟體AlphaGo已經能打敗人類棋手,未來AI會逐漸超越人類的智慧,因此需要讓AI對齊的手段,來限制這些超強AI的行為,使其表現,符合人類社會的規範與價值觀。

他強調,假設有一個人絕頂聰明,但心術不正,對社會來說並不好,而超智慧對齊,就是預防AI比人類更聰明、更厲害時,可能做出有害決定,或者有心人士利用AI做不好的事。

吳毅成舉例,利用AI監控街道,有助於快速抓到罪犯,但極權國家也可能用來監控人民隱私。

「對齊的東西一定做不完」,至於AI對齊或超智慧對齊有哪些具體作法,吳毅成強調,對齊就像資安、防毒軟體一樣,不可能有任何一個防毒軟體或資安技術,能保證100%擋下病毒或資安攻擊,AI對齊也必須不斷精進。

他也提到,目前常見的作法,包含拒絕詳實回答,像是不回答如何製作槍砲彈藥,再者則是發展符合在地文化的大型語言模型,例如國科會推動的大型語言模型TAIDE,特色即是具有「台灣價值」,在提供的資訊、使用的表達方式上,符合台灣的風土民情。

另外,吳毅成也說,AI對齊技術上可以持續精進,像是RLHF(Reinforcement Learning from Human Feedback,人類意見回饋強化學習)技術,利用人類的回饋,來完善大型語言模型,也是常見的作法。