輝達GPU機櫃熱散、訊號干擾問題陸續浮現 CPO技術是未來解方嗎?

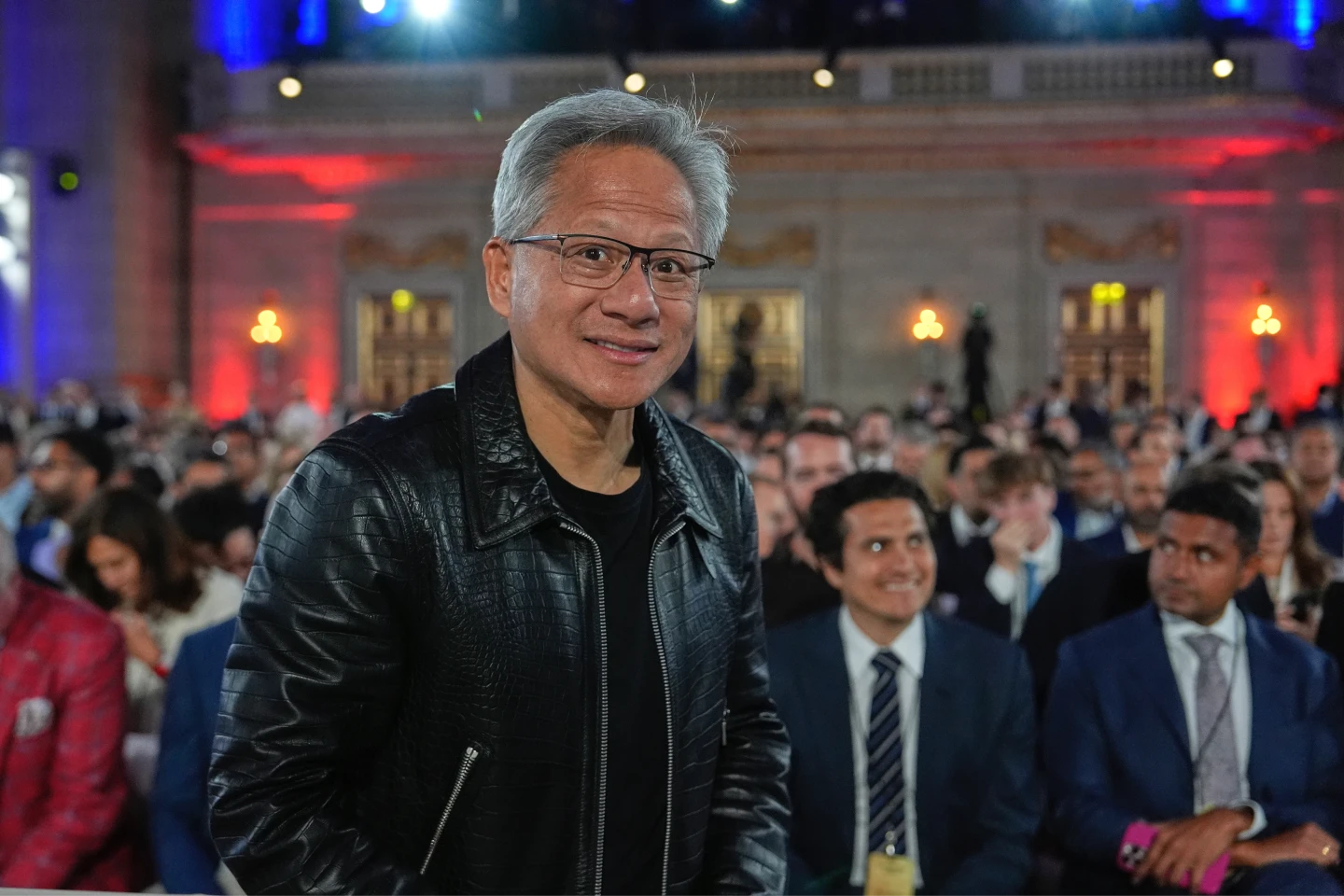

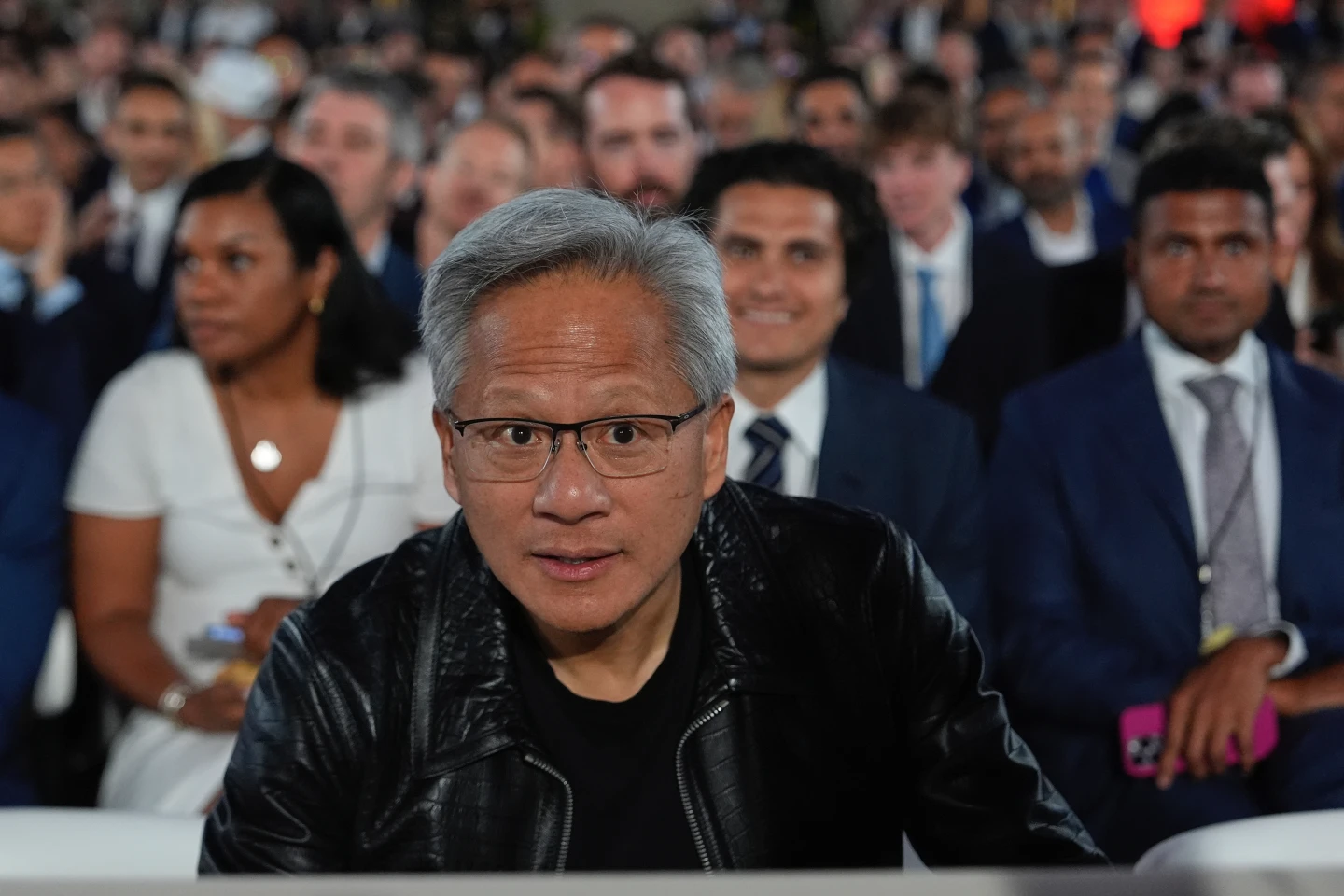

【財經中心/台北報導】儘管輝達穩居AI晶片龍頭地位,但隨著GPU 新品出現散熱問題、大客戶訂單受影響,如果輝達要保住「算力霸主」的寶座,可能急需一劑新解方。

科技大廠傳延遲Blackwell訂單

日前有消息稱,輝達將在今年3月的GTC大會上推出CPO(Co-Packaged Optics,共同光學封裝技術)交換器,若試產順利,有機會8月量產,屆時CPO交換器可實現115.2T的訊號傳輸。

根據陸媒科創板日報報導,儘管黃仁勳對外宣稱供貨一切順利,但目前GB200系列出貨不容樂觀,GB200 NVL72 機櫃設計複雜,高性能計算帶來高功耗及高散熱需求,零組件廠表示,單機櫃問題已經「大致解決」,但多機櫃連接問題「巨大」,機櫃連接需8萬根銅線,散熱、訊號干擾等問題陸續浮現,甚至已影響輝達大客戶訂單。

上周傳出,微軟、亞馬遜、谷歌和 Meta等公司已延遲Blackwell訂單,或直接「棄 B(Blackwell)投 H(Hopper)」。一方面,GB200的功耗「前所未有得高」,每個機櫃功耗達120~132千瓦,直接將傳統冷卻系統推向極限。

另一方面,Blackwell 機櫃還出現連接故障,阻礙熱量分配,也加劇熱管理問題。散熱互聯問題緊逼,輝達要怎麼解決?要晶片級優化,或是更先進冷卻方案,還是徹底改造機櫃?預期光通訊可能成為目前最佳技術解方,輝達也將目光投向CPO。

CPO近7年市場規模成長千倍

CPO是將光學元件與電路封裝於同一晶片中,縮短訊號傳輸距離,有效降低功耗,強化傳輸效率,已成為解決未來數據運算處理中巨量數據高速傳輸問題的重要技術途徑。

摩根士丹利在最新的AI供應鏈產業報告中指出,CPO具備AI數據中心的傳輸潛力,預估2023年至2030年期間,其市場規模將從800萬美元激增至93億美元,7年成長千倍,年複合成長率達172%。

之前傳出,輝達擬從今年下半年推出GB300晶片開始採CPO,Rubin平台(Blackwell下一代平台)也將採用該技術,以突破NVLink 72互連(最多可連接72個GB200晶片)的限制,提升通訊品質。

大摩指出,輝達的Rubin平台及其NVL伺服器機櫃系統,在導入CPO的能見度更高,且每系統中的內含價值更高,預估2027年佔全球CPO需求75%。

目前來看,輝達選擇CPO的方向似乎是正確的,除了輝達之外,包括AMD、思科、IBM、英特爾都是同行者。美國晶片大廠Marvell(美滿電子)日前就宣布,公司在訂製AI加速器架構取得突破,整合CPO技術,大幅提升伺服器性能。這種新架構能讓AI伺服器能力實現拓展,從目前使用銅互連的單機架的數十個XPU,拓展到橫跨多個機架的數百個XPU。

CPO量產至少還需1年以上

透過這架構,超大雲端服務商將能開發訂製XPU,實現更高頻寬密度,並在單個AI伺服器內提供更長距離的XPU到XPU連接,同時具有最佳延遲和功率效率。

去年底,IBM宣布實現重大CPO技術突破,可以「光速」訓練AI模型,同時節省大量能源。根據IBM結論,這項CPO技術能將標準大模型的訓練時間從3個月縮短至3周,且與中端電氣連接相比,能耗大幅降低,數據中心互連電纜的長度可以從1公尺延伸至數百公尺,大幅降低拓展生成式AI的成本。

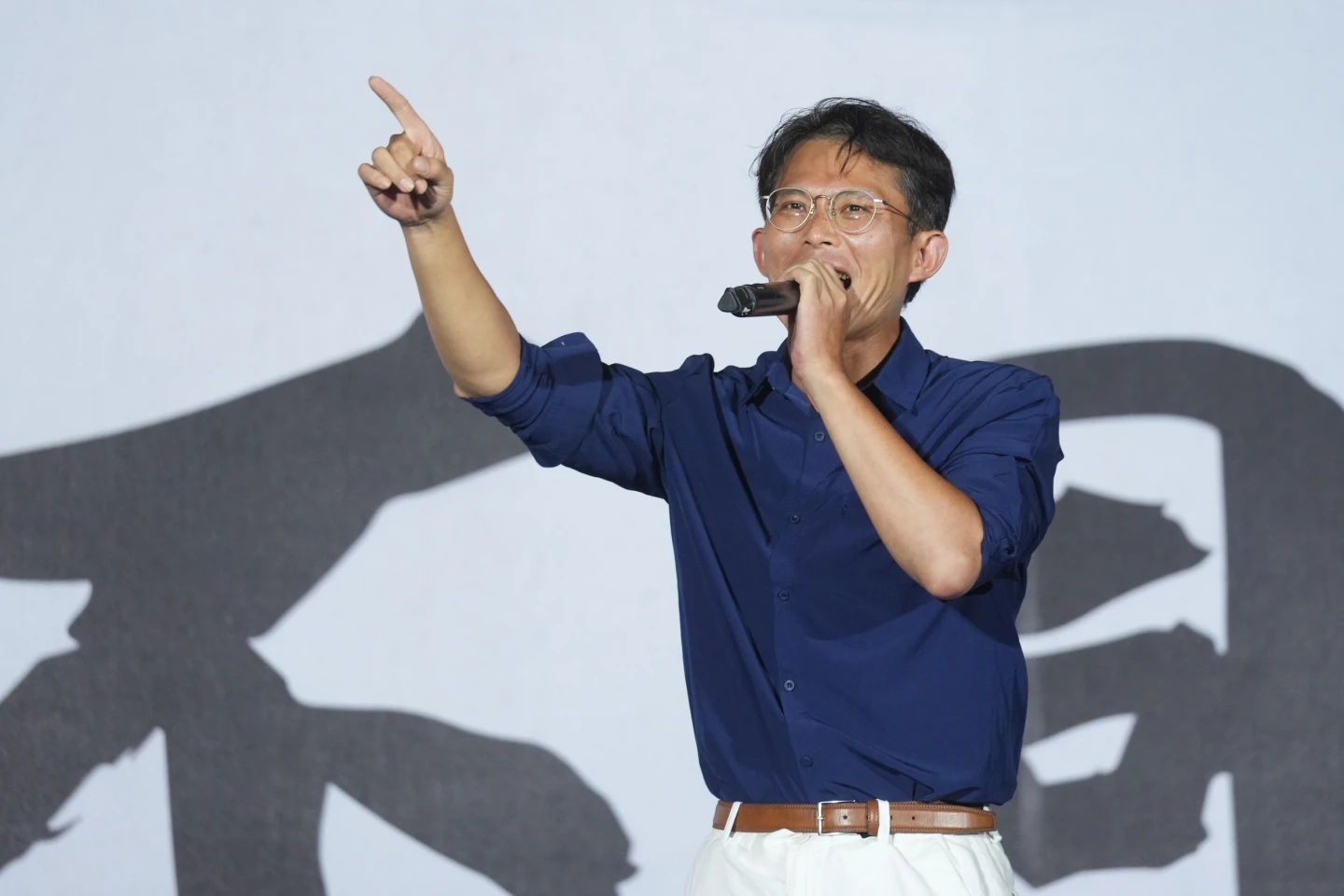

在上周法說會,身為輝達CPO的合作夥伴台積電董事長魏哲家表示,雖然CPO已有初步成果,但想要達到量產階段仍需要1年甚至1年半以上。

針對GB200伺服器散熱問題,黃仁勳上周也表示,Blackwell 平台散熱技術相對複雜,不過Blackwell系統已全面量產,初期面對的挑戰對比系統的複雜度,是很正常的,Blackwell 系統已開始銷售給全球客戶,顯示仍對未來出貨仍深具信心。